▶︎動画でも話してるので、文章読むのが面倒な方はこちらをみてもらえればと思います。

今回はStable Video Diffusionを使って画像から動画を生成する方法について解説します。

これを読めば誰でも簡単にクオリティーの高いAI美女が作れるようになっているので興味がある人は、下のバナーをクリックして購入してみてね🎶

Stable Video Diffusionを使って画像から動画を生成する方法について

この動画では、Stable Video DiffusionをComfyUIを使って動作させます。

そして、ComfyUIを動作させるためには有料版のGoogle Colabを利用します。

もしもGoogle Colabというキーワードが分からない場合は、以下に詳細を解説している記事を貼っておきますので、必要に応じてご利用ください。

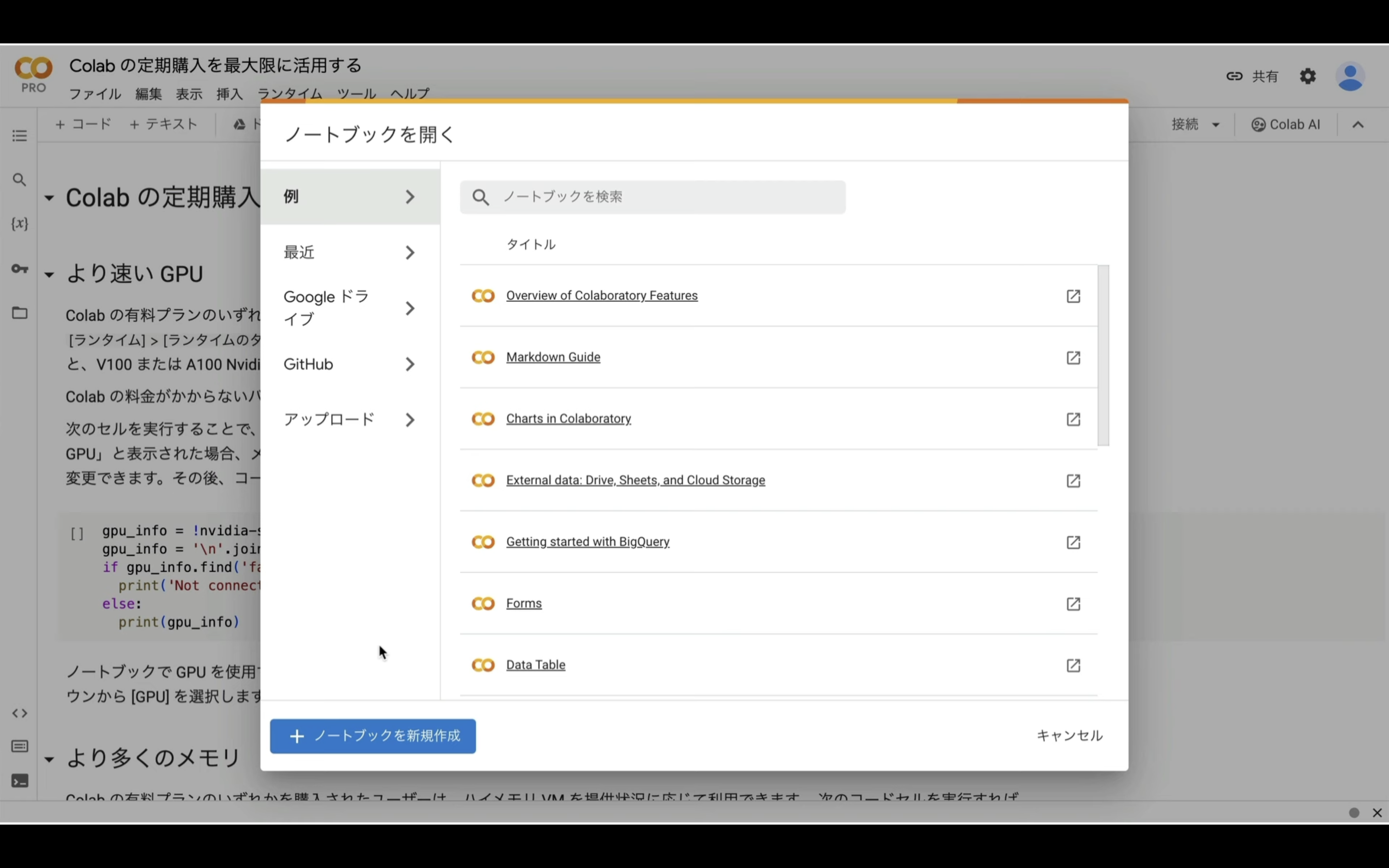

まずはGoogle Colabのサイトにアクセスします。

ここからの流れは下記に詳細リンクを貼っておきますので、そちらからご参照ください。

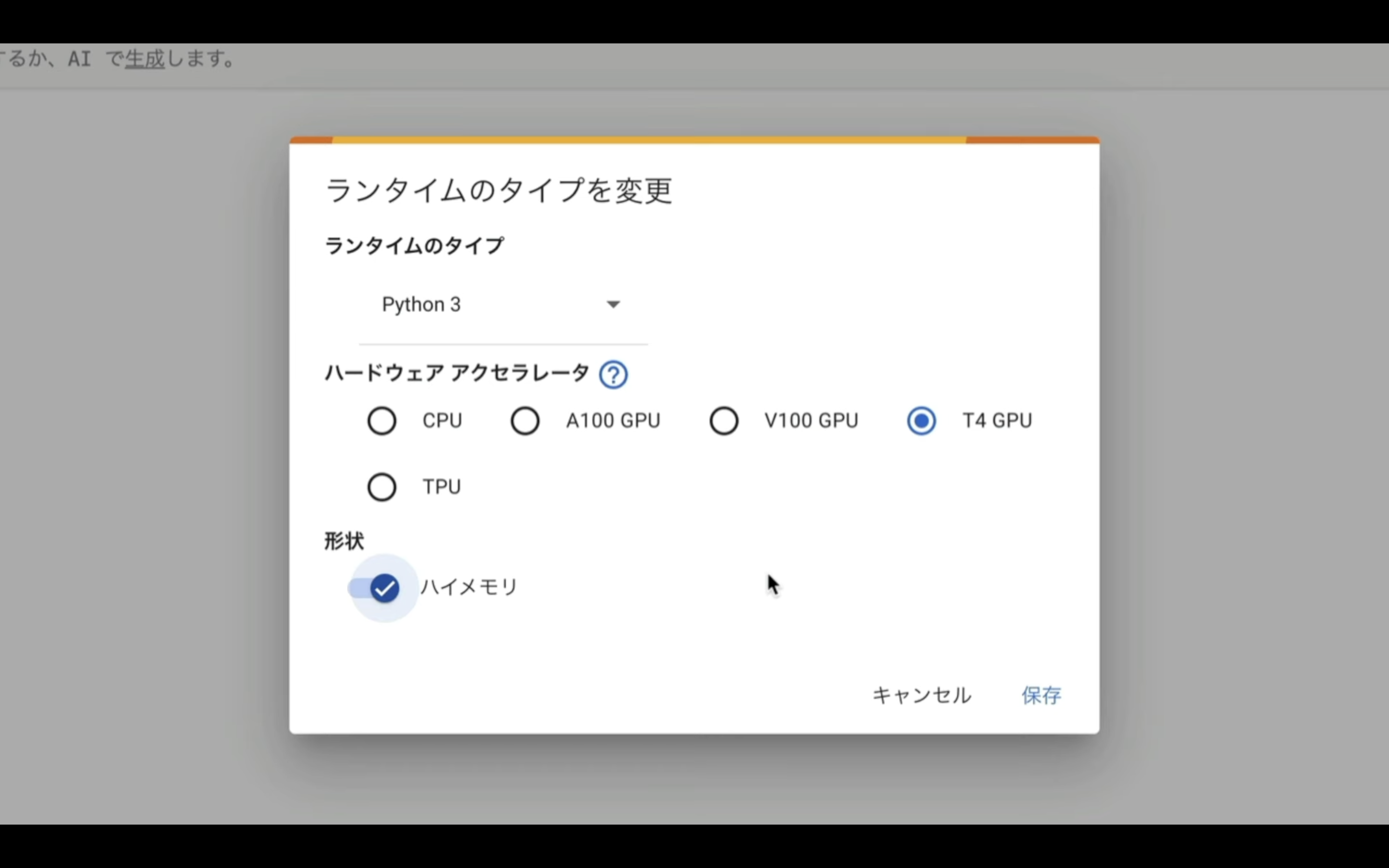

上記の記事では、ハイメモリの部分がOFFですが、今回はONにしておいてください。

これでGoogle Colabでソースコードを実行するための準備が整いました。

ソースコードを実行

それでは早速、動作させていきましょう。

概要欄に貼ってあるテキストをコピーします。

from pathlib import Path

import subprocess

import threading

import time

import socket

!pip install -q torch==2.0.1+cu118 torchvision==0.15.2+cu118 torchaudio==2.0.2+cu118 torchtext==0.15.2 torchdata==0.6.1 --extra-index-url https://download.pytorch.org/whl/cu118 -U

!pip install -q xformers==0.0.20 triton==2.0.0 gradio_client==0.2.7 -U

!apt -y install -qq aria2

!pip install controlnet-aux==0.0.7 onnxruntime-gpu

# 定数と設定

WORKSPACE = '/content/ComfyUI'

UPDATE_COMFY_UI = True

# ComfyUIのセットアップと更新

if not Path(WORKSPACE).exists():

%cd /content

print("-= Initial setup ComfyUI =-")

!git clone https://github.com/comfyanonymous/ComfyUI

else:

%cd $WORKSPACE

print("-= Updating ComfyUI =-")

!git pull

%cd $WORKSPACE/custom_nodes

!git clone https://github.com/Kosinkadink/ComfyUI-VideoHelperSuite

!git clone https://github.com/ssitu/ComfyUI_UltimateSDUpscale --recursive

!git clone https://github.com/TinyTerra/ComfyUI_tinyterraNodes

!git clone https://github.com/Kosinkadink/ComfyUI-Advanced-ControlNet

!git clone https://github.com/Kosinkadink/ComfyUI-AnimateDiff-Evolved

!git clone https://github.com/FizzleDorf/ComfyUI_FizzNodes

!git clone https://github.com/Stability-AI/stability-ComfyUI-nodes

!git clone https://github.com/RockOfFire/ComfyUI_Comfyroll_CustomNodes

!git clone https://github.com/ltdrdata/ComfyUI-Manager.git

!git clone https://github.com/mcmonkeyprojects/sd-dynamic-thresholding

!git clone https://github.com/laksjdjf/IPAdapter-ComfyUI.git

!git clone https://github.com/Fannovel16/comfyui_controlnet_aux.git

!git clone https://github.com/Fannovel16/ComfyUI-Frame-Interpolation

!git clone https://github.com/rgthree/rgthree-comfy

!aria2c --console-log-level=error -c -x 16 -s 16 -k 1M https://huggingface.co/h94/IP-Adapter/resolve/main/models/ip-adapter-plus-face_sd15.bin -d /content/ComfyUI/custom_nodes/IPAdapter-ComfyUI/models -o ip-adapter-plus-face_sd15.bin

!aria2c --console-log-level=error -c -x 16 -s 16 -k 1M https://huggingface.co/h94/IP-Adapter/resolve/main/models/image_encoder/model.safetensors -d /content/ComfyUI/models/clip_vision/ip_adapter -o model.safetensors

!aria2c --console-log-level=error -c -x 16 -s 16 -k 1M https://huggingface.co/embed/upscale/resolve/main/4x-UltraSharp.pth -d /content/ComfyUI/models/upscale_models -o 4x-UltraSharp.pth

# アニメーションモデルのダウンロード

!aria2c --console-log-level=error -c -x 16 -s 16 -k 1M https://huggingface.co/guoyww/animatediff/resolve/main/mm_sd_v15_v2.ckpt -d /content/ComfyUI/custom_nodes/ComfyUI-AnimateDiff-Evolved/models -o mm_sd_v15_v2.ckpt

# ネガティブプロンプト

!git clone https://huggingface.co/embed/negative $WORKSPACE/models/embeddings/negative

!wget -c -P $WORKSPACE/models/embeddings/negative/

!aria2c --console-log-level=error -c -x 16 -s 16 -k 1M https://civitai.com/api/download/models/77169 -d /content/ComfyUI/models/upscale_models -o BadDream.pt

!aria2c --console-log-level=error -c -x 16 -s 16 -k 1M https://civitai.com/api/download/models/77173 -d /content/ComfyUI/models/upscale_models -o UnrealisticDream.pt

!aria2c --console-log-level=error -c -x 16 -s 16 -k 1M https://civitai.com/api/download/models/25820 -d /content/ComfyUI/models/upscale_models -o verybadimagenegative_v1.3.pt

%cd $WORKSPACE

# 依存関係のインストール

print("-= Install dependencies =-")

!pip install xformers!=0.0.18 -r requirements.txt --extra-index-url https://download.pytorch.org/whl/cu118 --extra-index-url https://download.pytorch.org/whl/cu118

# VAEのダウンロード

!wget -c https://huggingface.co/stabilityai/sd-vae-ft-mse-original/resolve/main/vae-ft-mse-840000-ema-pruned.safetensors -P ./models/vae/

#checkpointをダウンロード

!aria2c --console-log-level=error -c -x 16 -s 16 -k 1M https://huggingface.co/runwayml/stable-diffusion-v1-5/resolve/main/v1-5-pruned-emaonly.ckpt -d $WORKSPACE/models/checkpoints -o v1-5-pruned-emaonly.ckpt

!aria2c --console-log-level=error -c -x 16 -s 16 -k 1M https://huggingface.co/stabilityai/stable-video-diffusion-img2vid/resolve/main/svd.safetensors -d $WORKSPACE/models/checkpoints -o svd.safetensors

!aria2c --console-log-level=error -c -x 16 -s 16 -k 1M https://huggingface.co/stabilityai/stable-video-diffusion-img2vid-xt/resolve/main/svd_xt.safetensors -d $WORKSPACE/models/checkpoints -o svd_xt.safetensors

#ControlNetのダウンロード

!wget -c https://huggingface.co/comfyanonymous/ControlNet-v1-1_fp16_safetensors/resolve/main/control_v11e_sd15_ip2p_fp16.safetensors -P ./models/controlnet/

!wget -c https://huggingface.co/comfyanonymous/ControlNet-v1-1_fp16_safetensors/resolve/main/control_v11e_sd15_shuffle_fp16.safetensors -P ./models/controlnet/

!wget -c https://huggingface.co/comfyanonymous/ControlNet-v1-1_fp16_safetensors/resolve/main/control_v11p_sd15_canny_fp16.safetensors -P ./models/controlnet/

!wget -c https://huggingface.co/comfyanonymous/ControlNet-v1-1_fp16_safetensors/resolve/main/control_v11f1p_sd15_depth_fp16.safetensors -P ./models/controlnet/

!wget -c https://huggingface.co/comfyanonymous/ControlNet-v1-1_fp16_safetensors/resolve/main/control_v11p_sd15_inpaint_fp16.safetensors -P ./models/controlnet/

!wget -c https://huggingface.co/comfyanonymous/ControlNet-v1-1_fp16_safetensors/resolve/main/control_v11p_sd15_lineart_fp16.safetensors -P ./models/controlnet/

!wget -c https://huggingface.co/comfyanonymous/ControlNet-v1-1_fp16_safetensors/resolve/main/control_v11p_sd15_mlsd_fp16.safetensors -P ./models/controlnet/

!wget -c https://huggingface.co/comfyanonymous/ControlNet-v1-1_fp16_safetensors/resolve/main/control_v11p_sd15_normalbae_fp16.safetensors -P ./models/controlnet/

!wget -c https://huggingface.co/comfyanonymous/ControlNet-v1-1_fp16_safetensors/resolve/main/control_v11p_sd15_openpose_fp16.safetensors -P ./models/controlnet/

!wget -c https://huggingface.co/comfyanonymous/ControlNet-v1-1_fp16_safetensors/resolve/main/control_v11p_sd15_scribble_fp16.safetensors -P ./models/controlnet/

!wget -c https://huggingface.co/comfyanonymous/ControlNet-v1-1_fp16_safetensors/resolve/main/control_v11p_sd15_seg_fp16.safetensors -P ./models/controlnet/

!wget -c https://huggingface.co/comfyanonymous/ControlNet-v1-1_fp16_safetensors/resolve/main/control_v11p_sd15_softedge_fp16.safetensors -P ./models/controlnet/

!wget -c https://huggingface.co/comfyanonymous/ControlNet-v1-1_fp16_safetensors/resolve/main/control_v11p_sd15s2_lineart_anime_fp16.safetensors -P ./models/controlnet/

!wget -c https://huggingface.co/comfyanonymous/ControlNet-v1-1_fp16_safetensors/resolve/main/control_v11u_sd15_tile_fp16.safetensors -P ./models/controlnet/

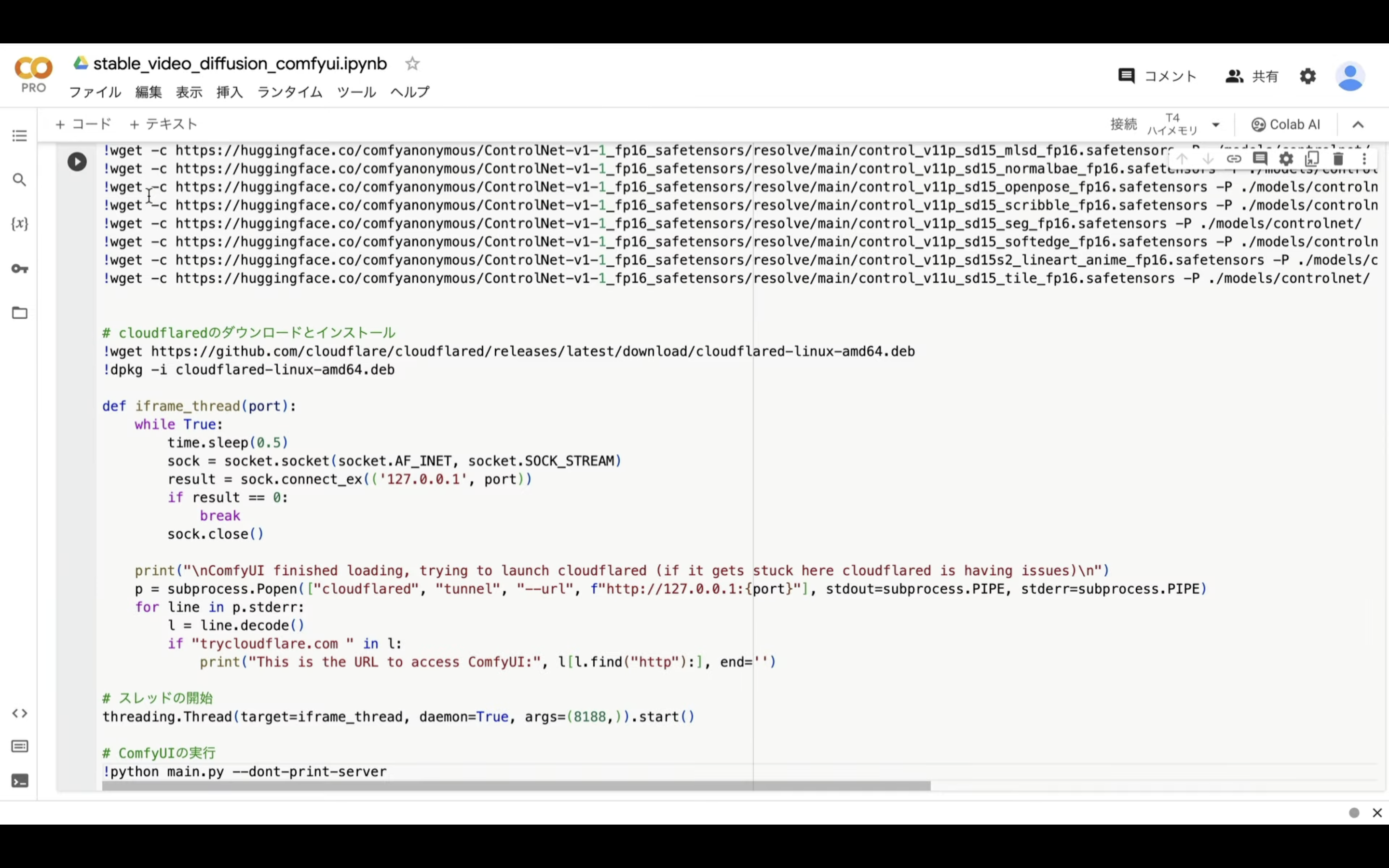

# cloudflaredのダウンロードとインストール

!wget https://github.com/cloudflare/cloudflared/releases/latest/download/cloudflared-linux-amd64.deb

!dpkg -i cloudflared-linux-amd64.deb

def iframe_thread(port):

while True:

time.sleep(0.5)

sock = socket.socket(socket.AF_INET, socket.SOCK_STREAM)

result = sock.connect_ex(('127.0.0.1', port))

if result == 0:

break

sock.close()

print("\nComfyUI finished loading, trying to launch cloudflared (if it gets stuck here cloudflared is having issues)\n")

p = subprocess.Popen(["cloudflared", "tunnel", "--url", f"http://127.0.0.1:{port}"], stdout=subprocess.PIPE, stderr=subprocess.PIPE)

for line in p.stderr:

l = line.decode()

if "trycloudflare.com " in l:

print("This is the URL to access ComfyUI:", l[l.find("http"):], end='')

# スレッドの開始

threading.Thread(target=iframe_thread, daemon=True, args=(8188,)).start()

# ComfyUIの実行

!python main.py --dont-print-server

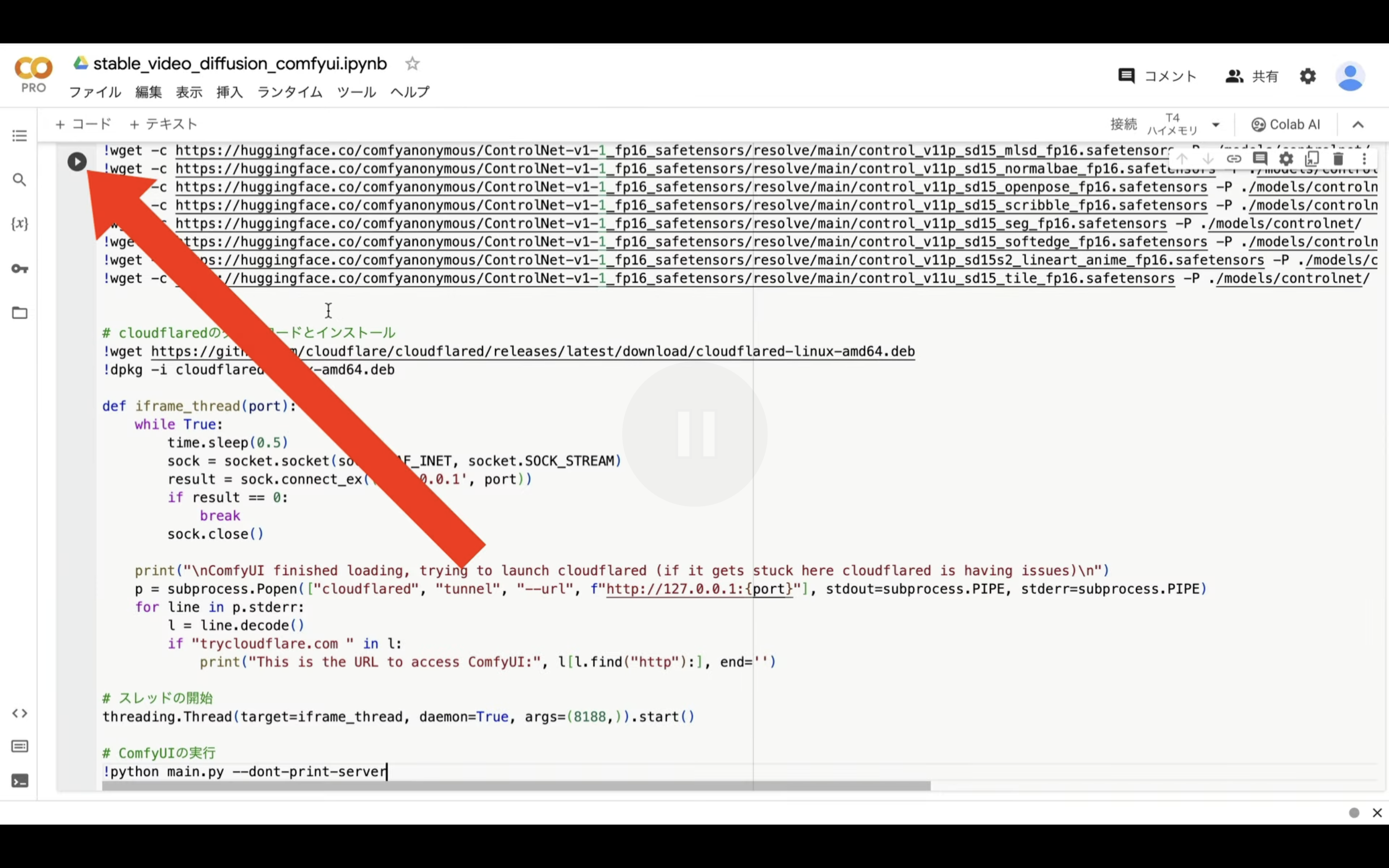

テキストをコピーしたら、Google Colabの画面に戻り、そしてテキストボックスに先ほどコピーしたテキストを貼り付けます。

テキストを貼り付けたら、左上にある再生ボタンを押します。

これでコマンドが実行されます。コマンドの実行には5分以上かかると思います。

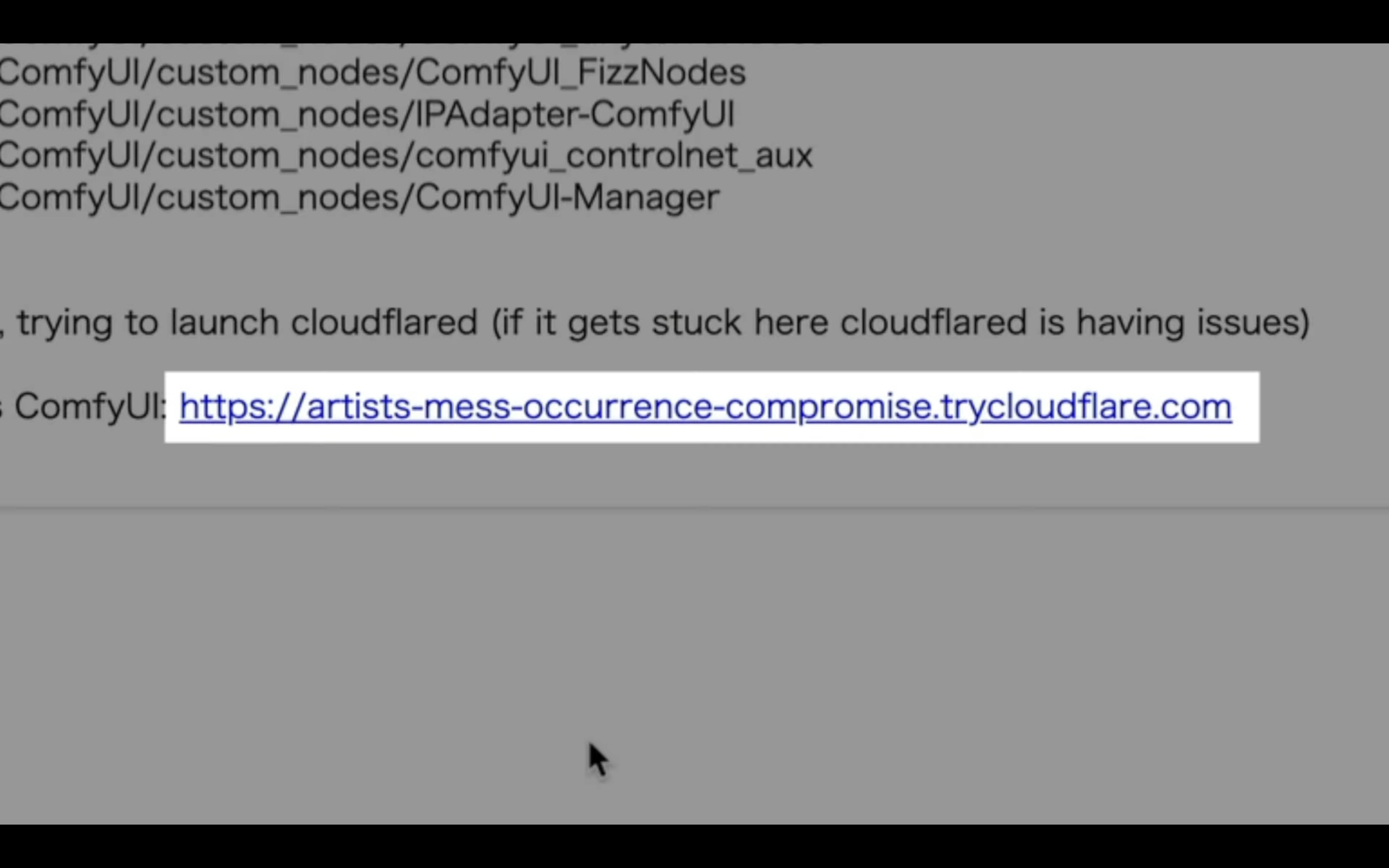

しばらく待っていると、このようなURLが表示されます。

このURLをクリックします。

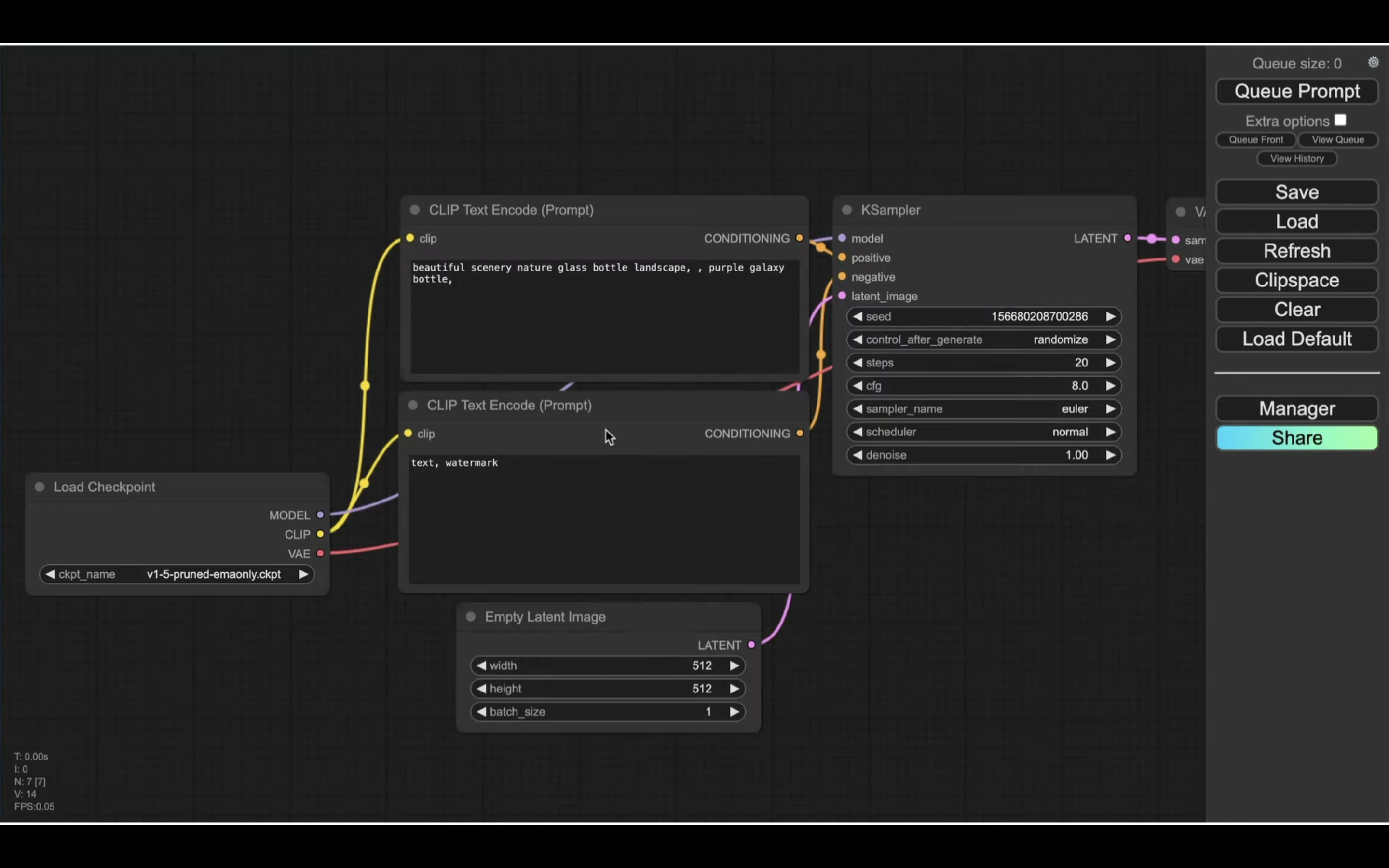

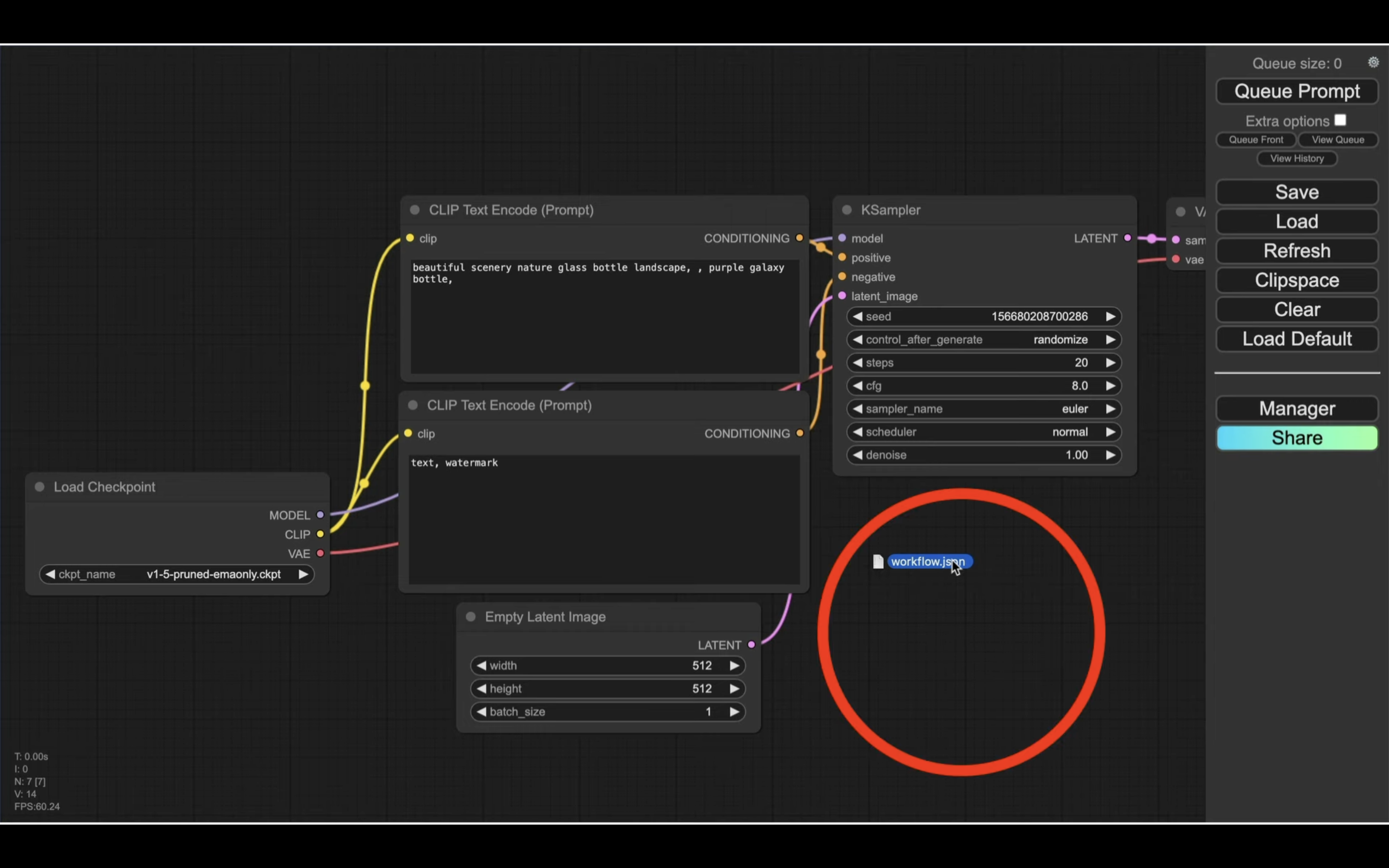

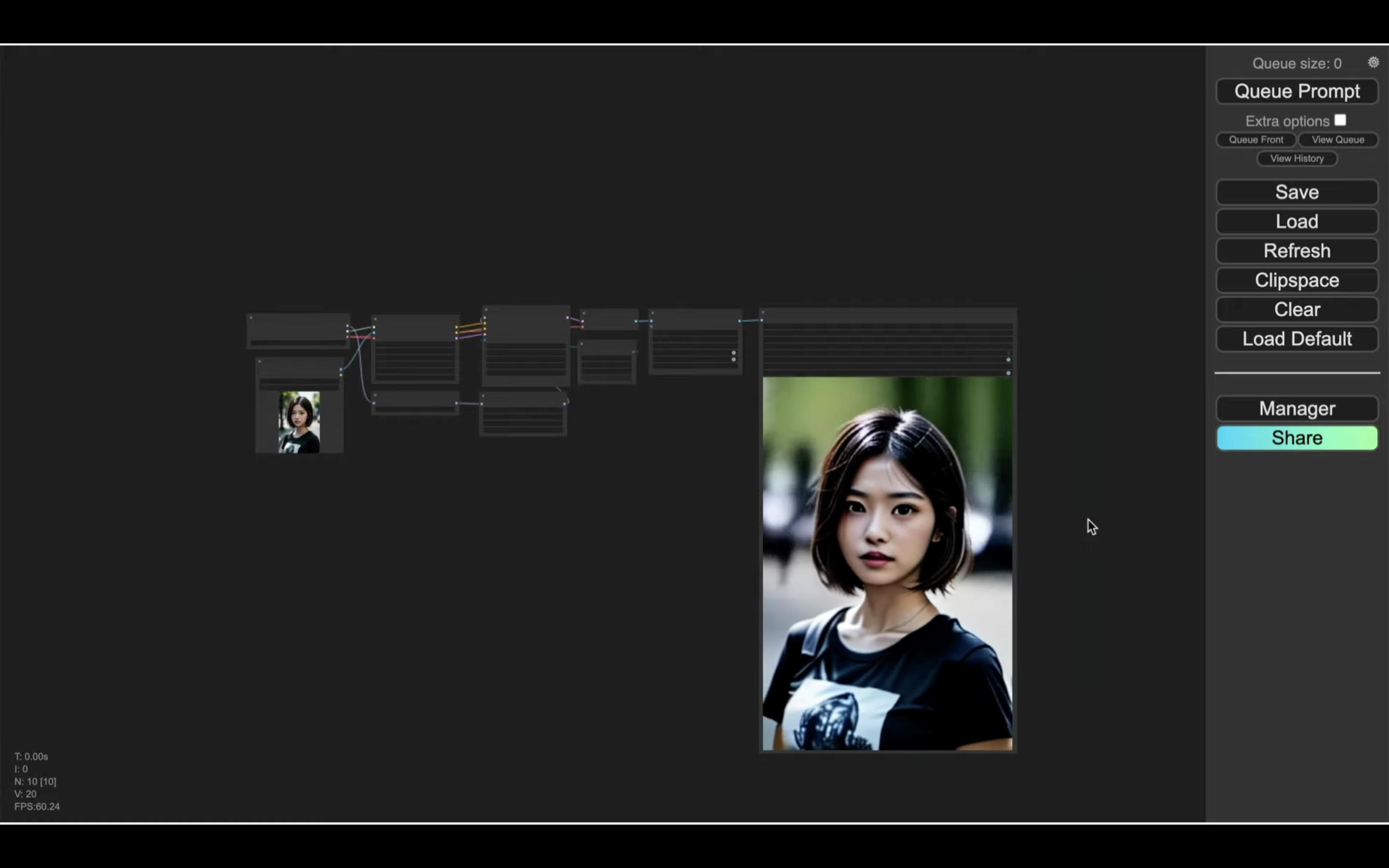

そうすると、ComfyUIの画面が表示されます。

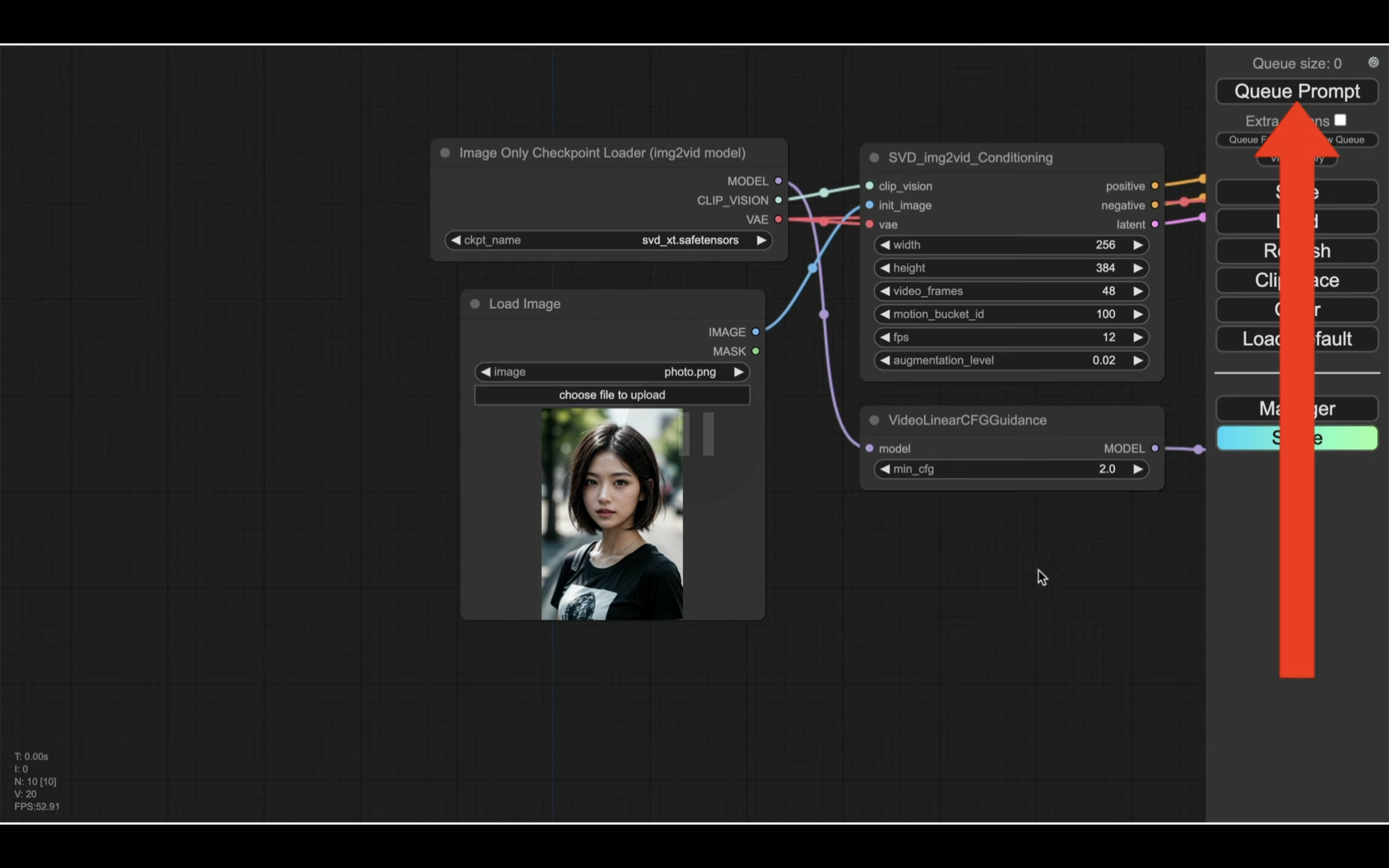

この画面でStable Video Diffusionを動作させていきます。

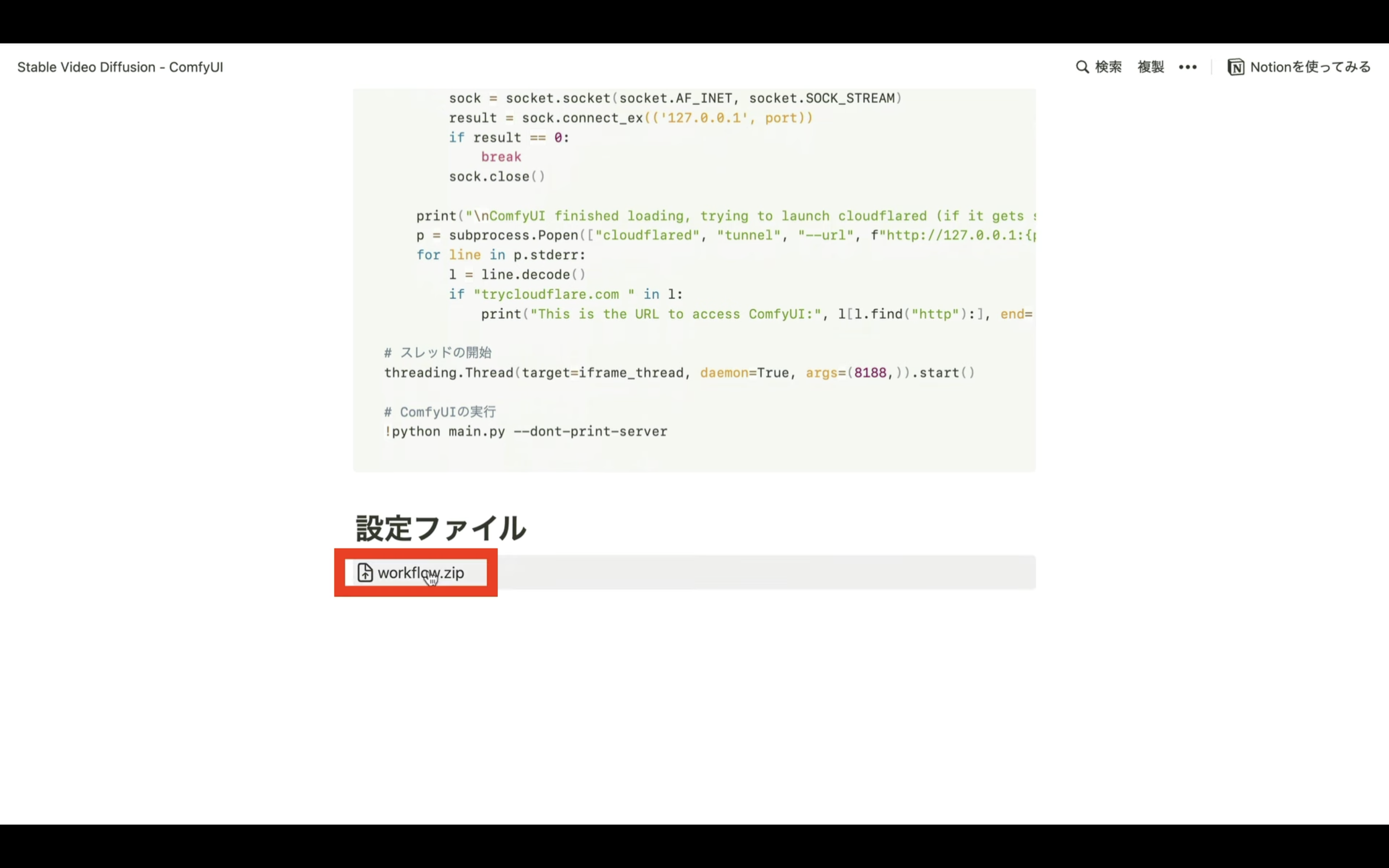

この解説では、あらかじめStable Video Diffusionを動作させるための設定ファイルを用意してあります。

設定ファイルは下に貼ってあるリンク先のページから取得できます。

このページにある「設定ファイル」というタイトルの下のworkflow.zipをクリックします。

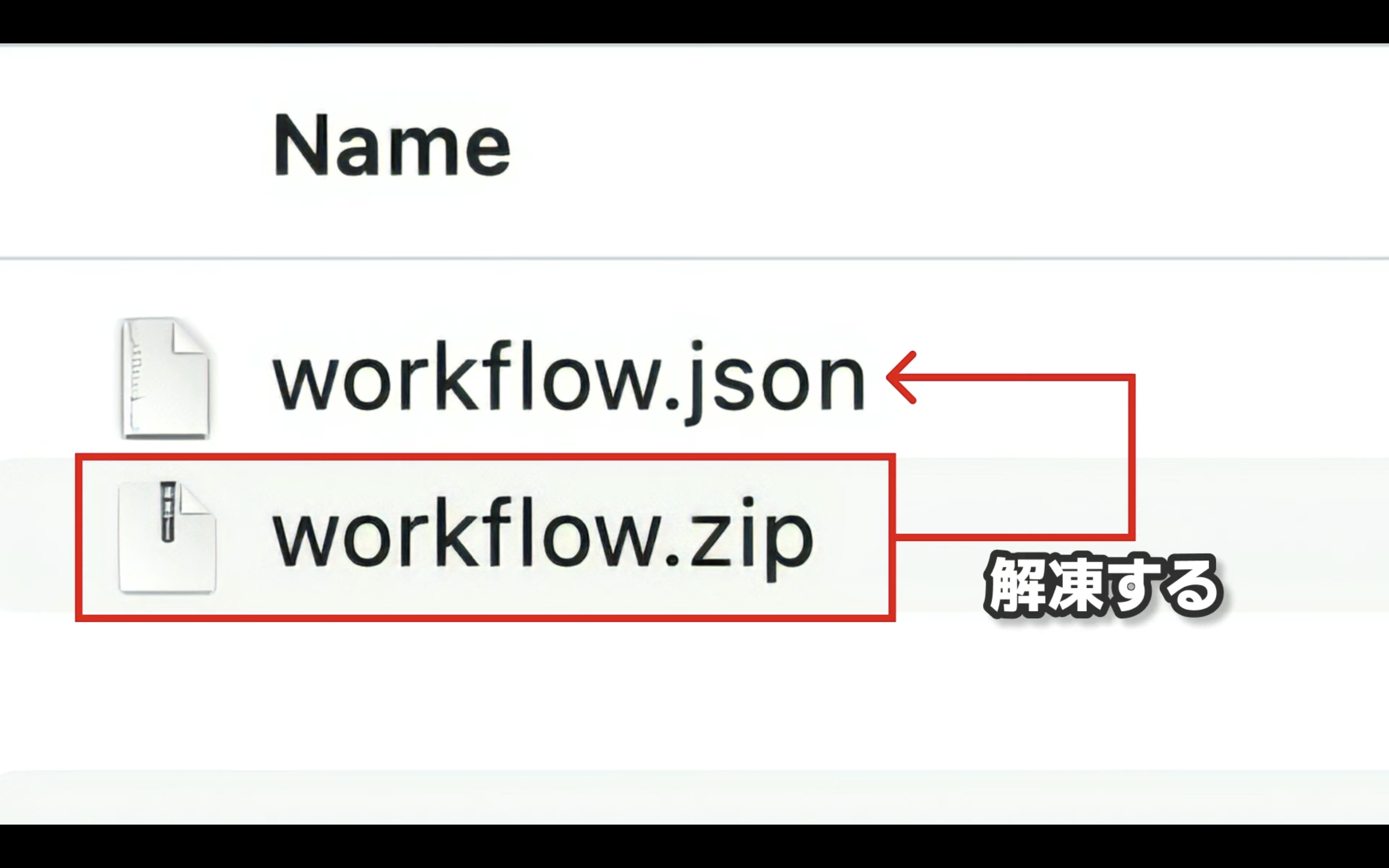

そうするとStable Video Diffusionを動作させるための設定ファイルがダウンロードされます。

ダウンロードされたZIPファイルを解凍するとworkflow.jsonという名前のファイルが生成されます。

このファイルを先ほどのComfyUIの画面にドラッグ&ドロップします。

ドラッグ&ドロップする場所は、できるだけ何も表示されていない箇所を選びましょう。

これで設定ファイルが読み込まれます。

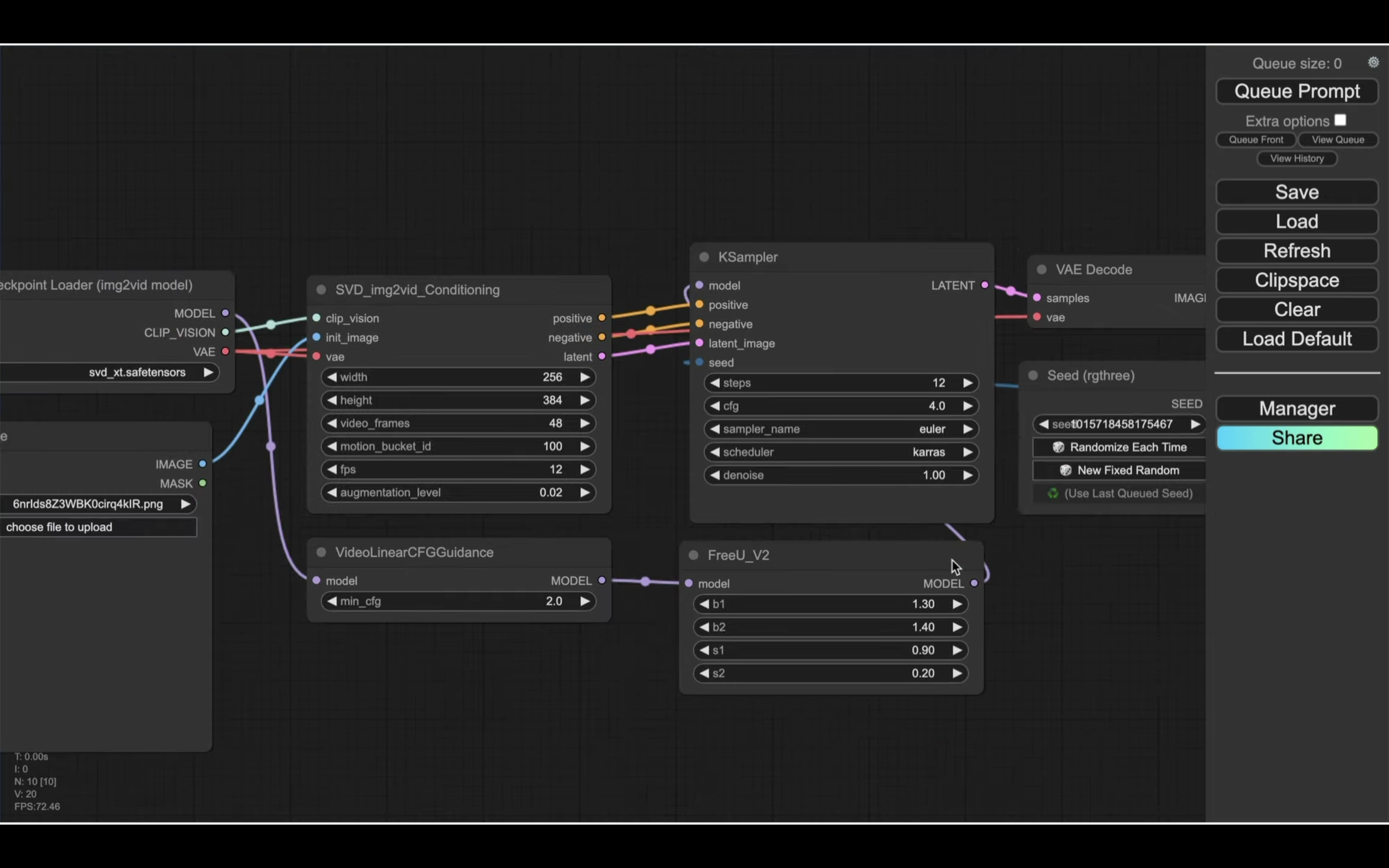

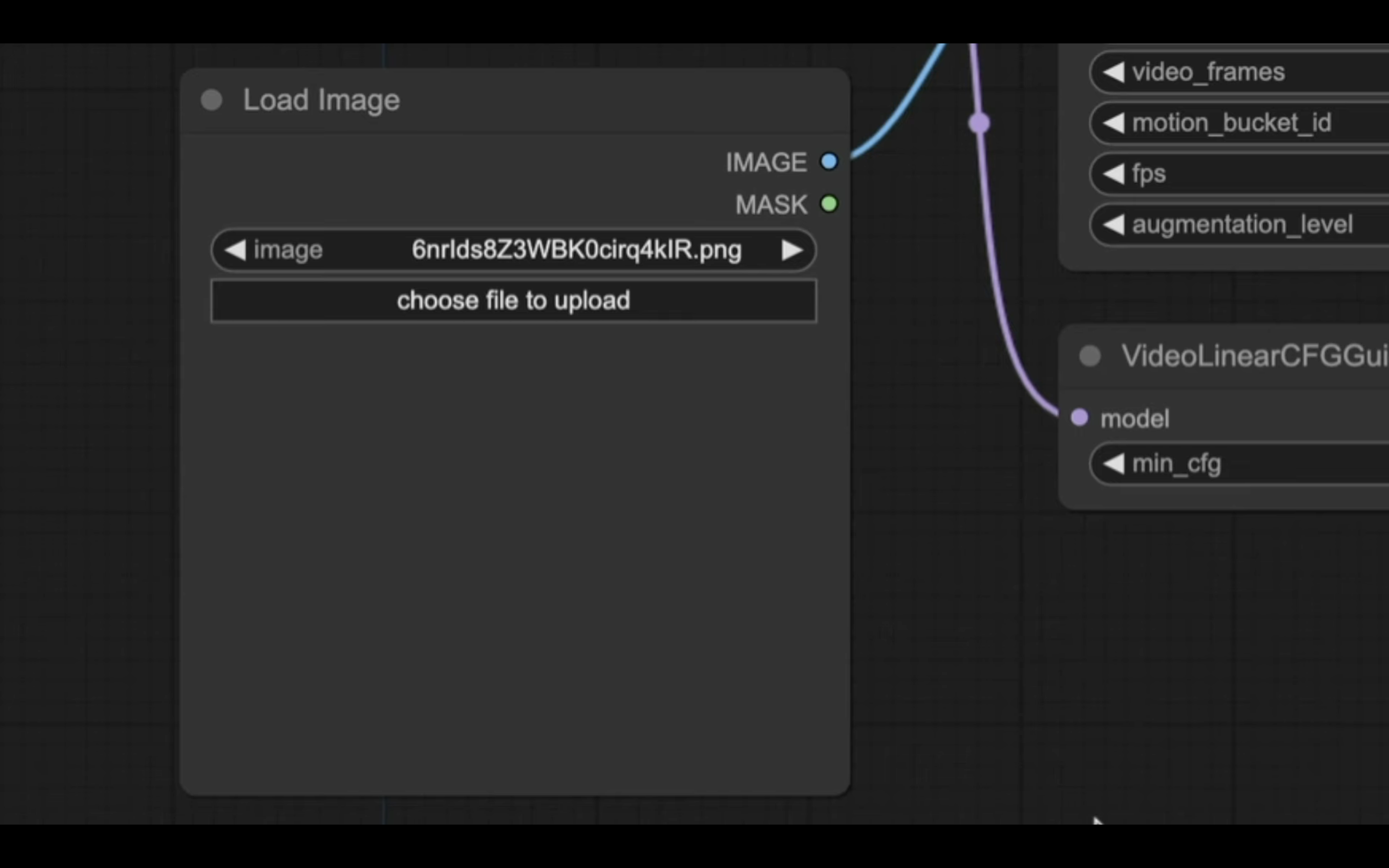

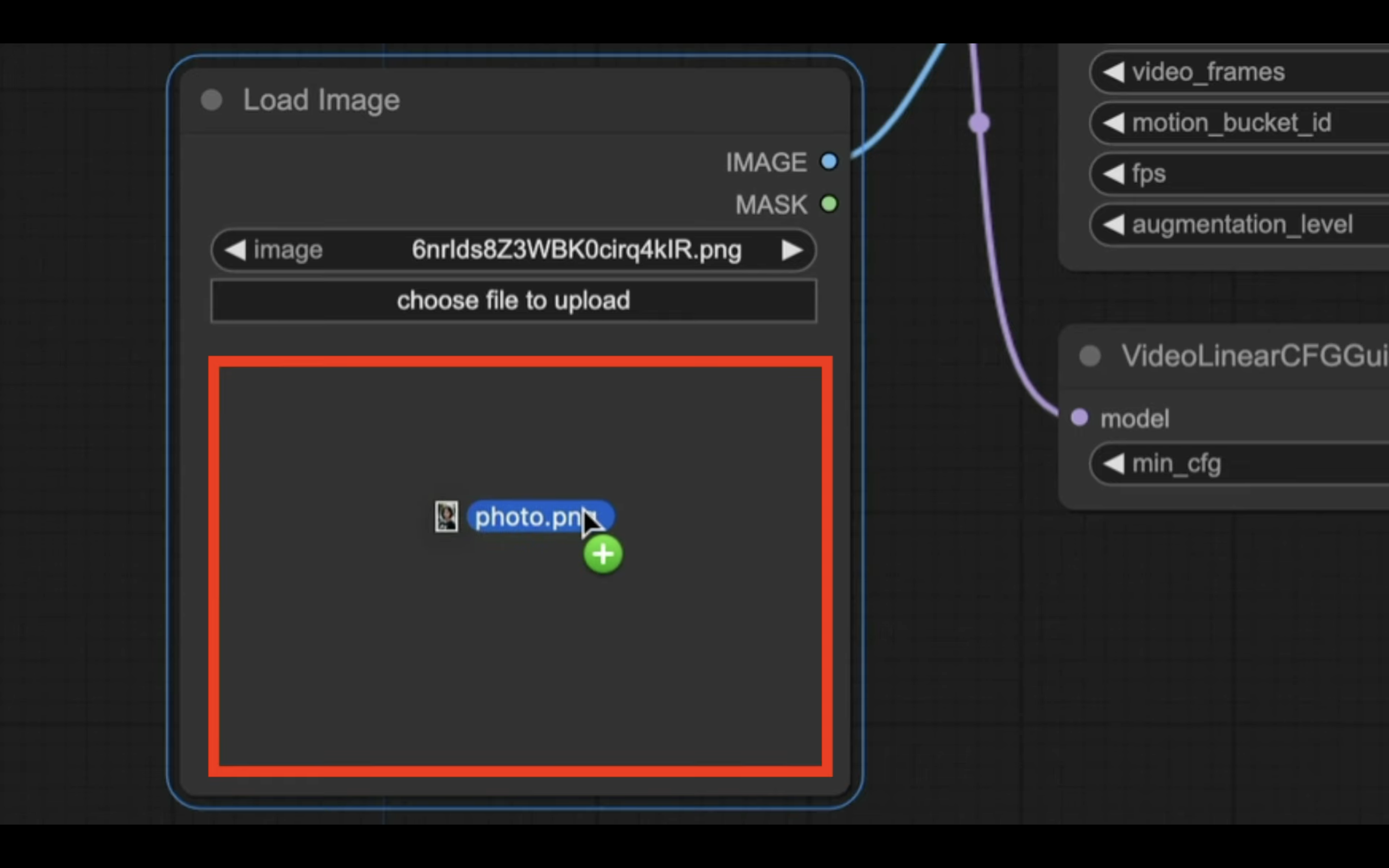

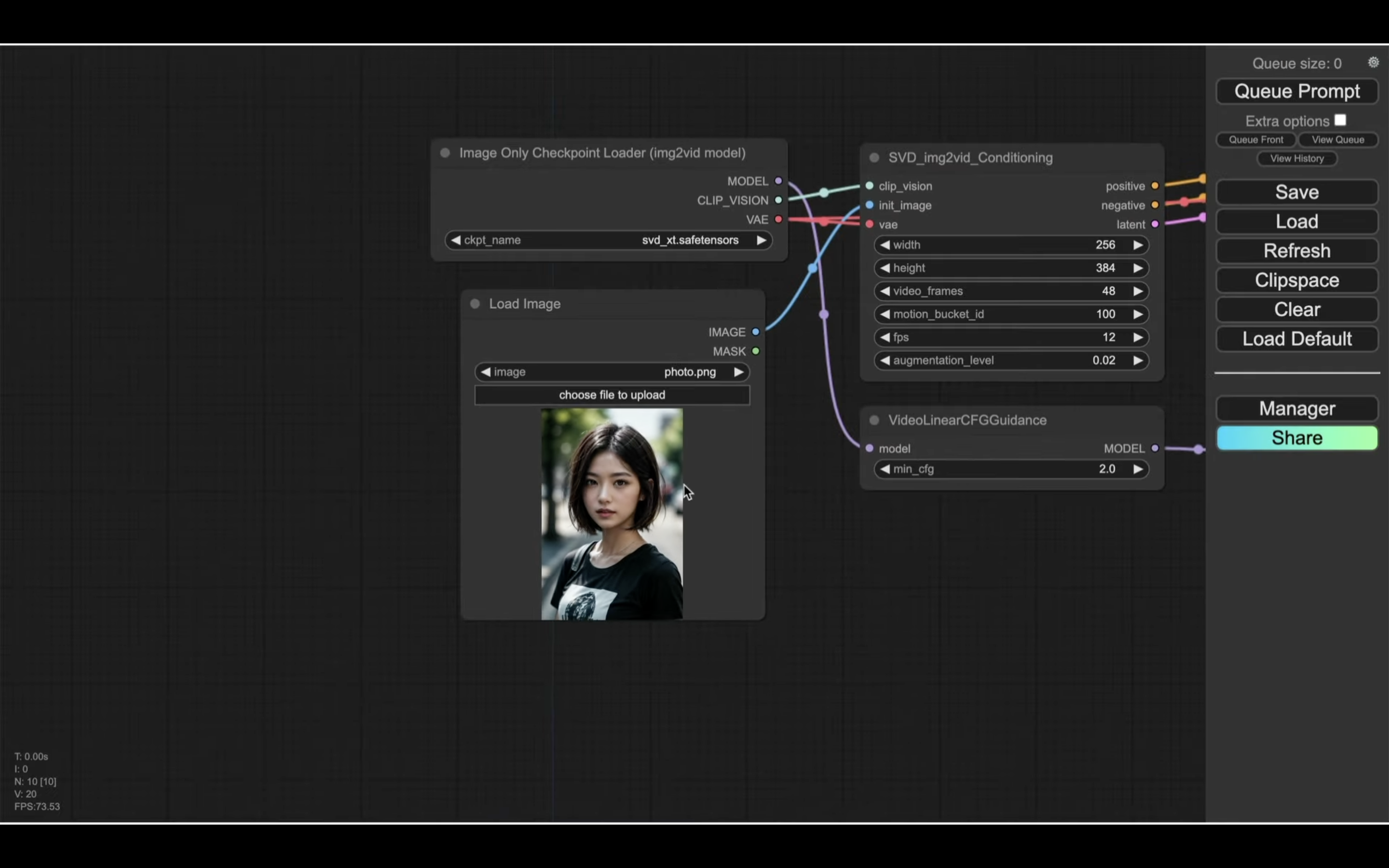

設定ファイルが読み込まれたら、「Load Image」というタイトルのブロックで、動画を作成する元になる画像を指定します。

具体的には、この部分に画像ファイルをドラッグ&ドロップします。

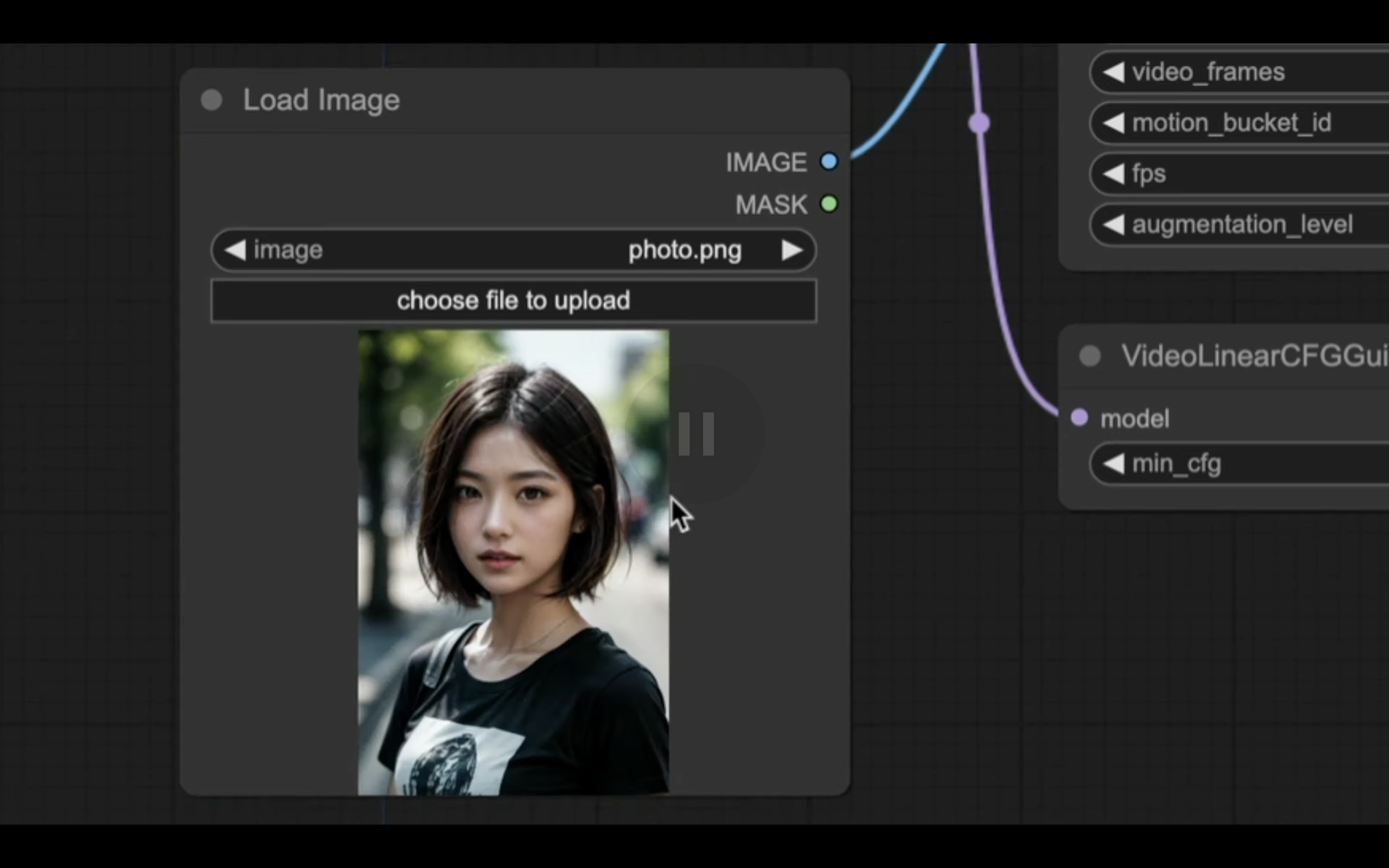

今回は、この画像を設定してみました。

これでStable Video Diffusionを実行するための準備が整いました。

それでは、早速実行していきましょう。

「Queue Prompt」と書かれているボタンをクリックします。

そうすると動画の生成が開始されます。

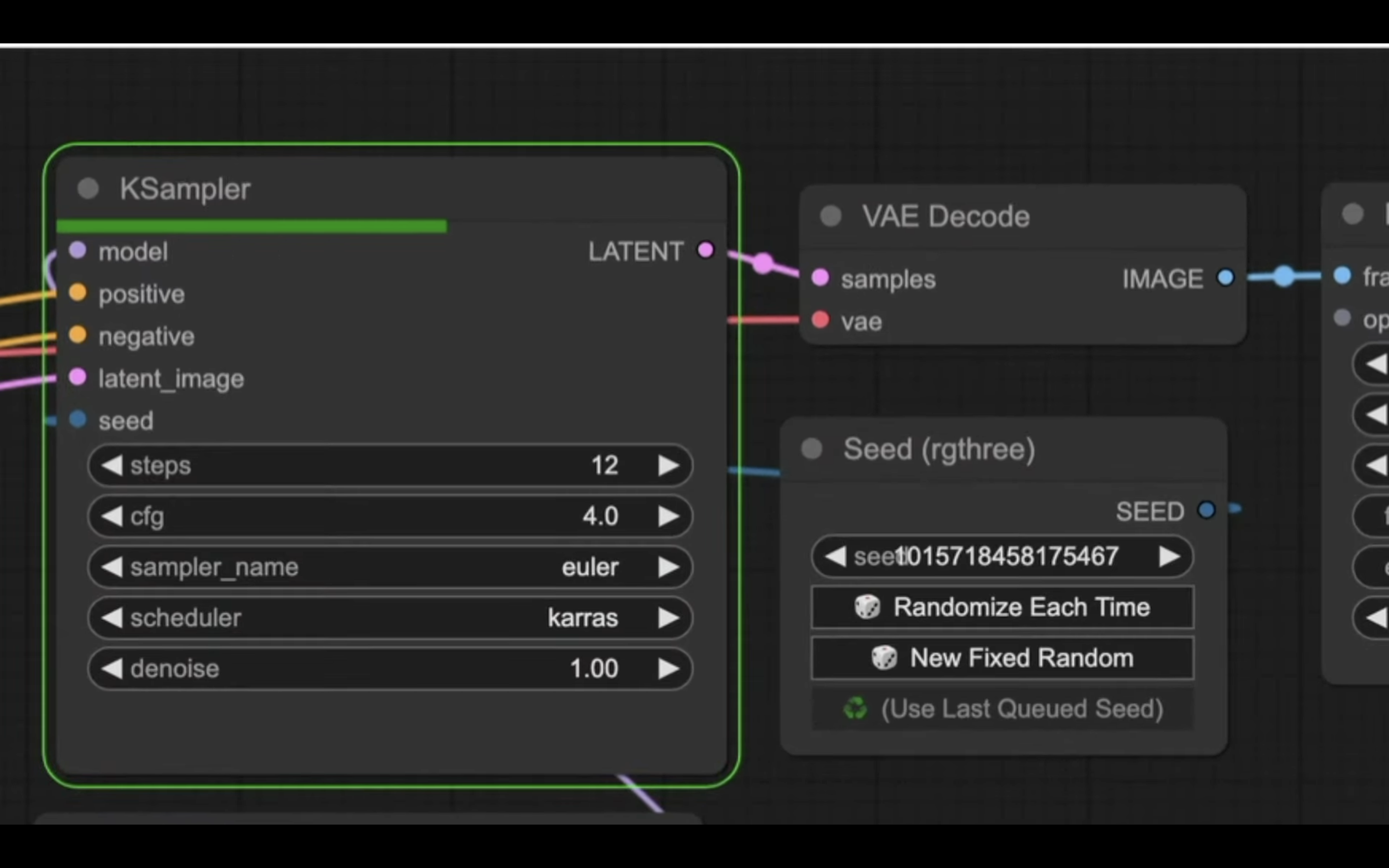

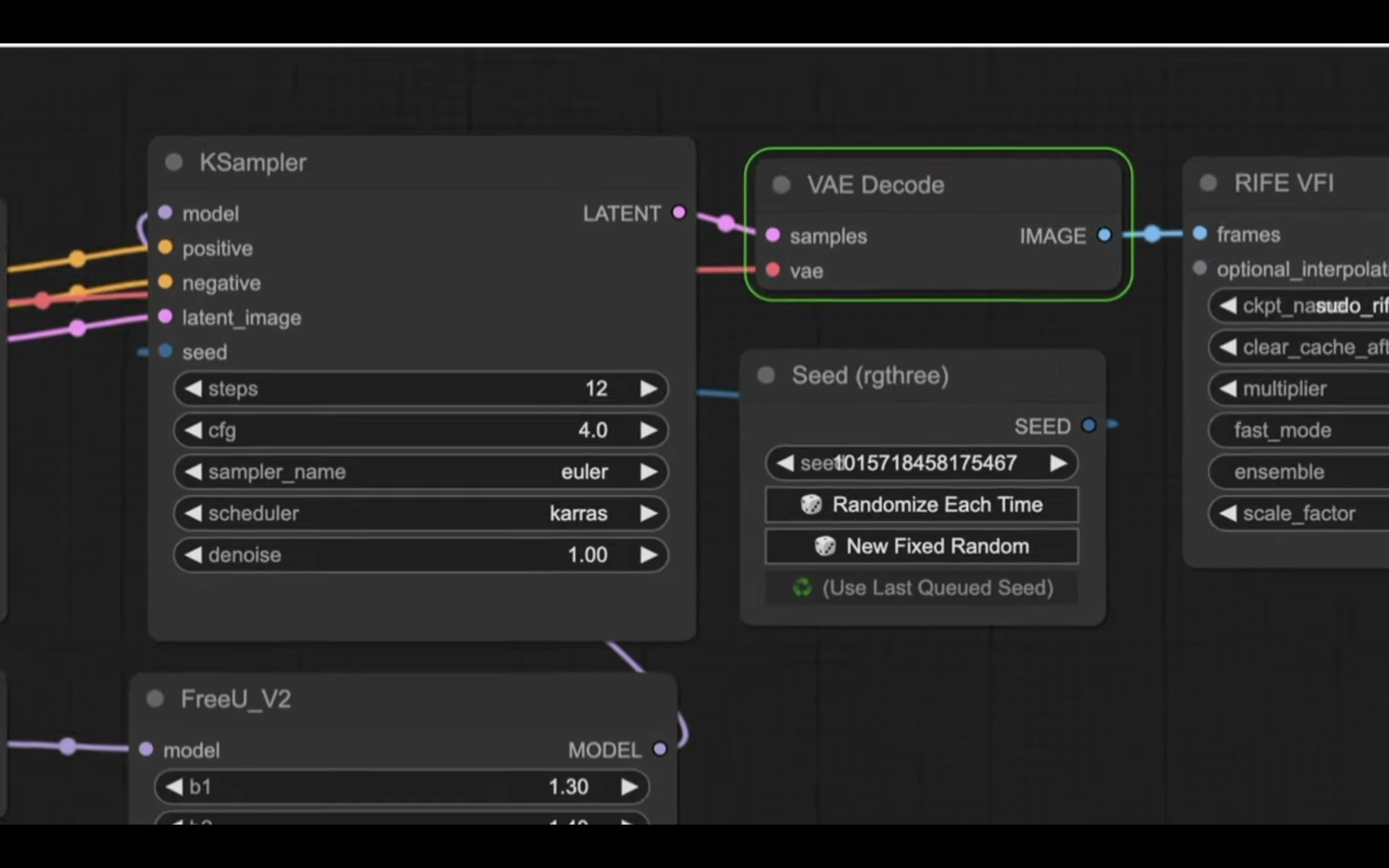

ブロックの周りが緑色になっている場所が現在処理されている内容です。

そのため、処理が完了するとこの緑色で囲まれている表示が移動します。

これらの処理が完了するまでには数分程度かかります。

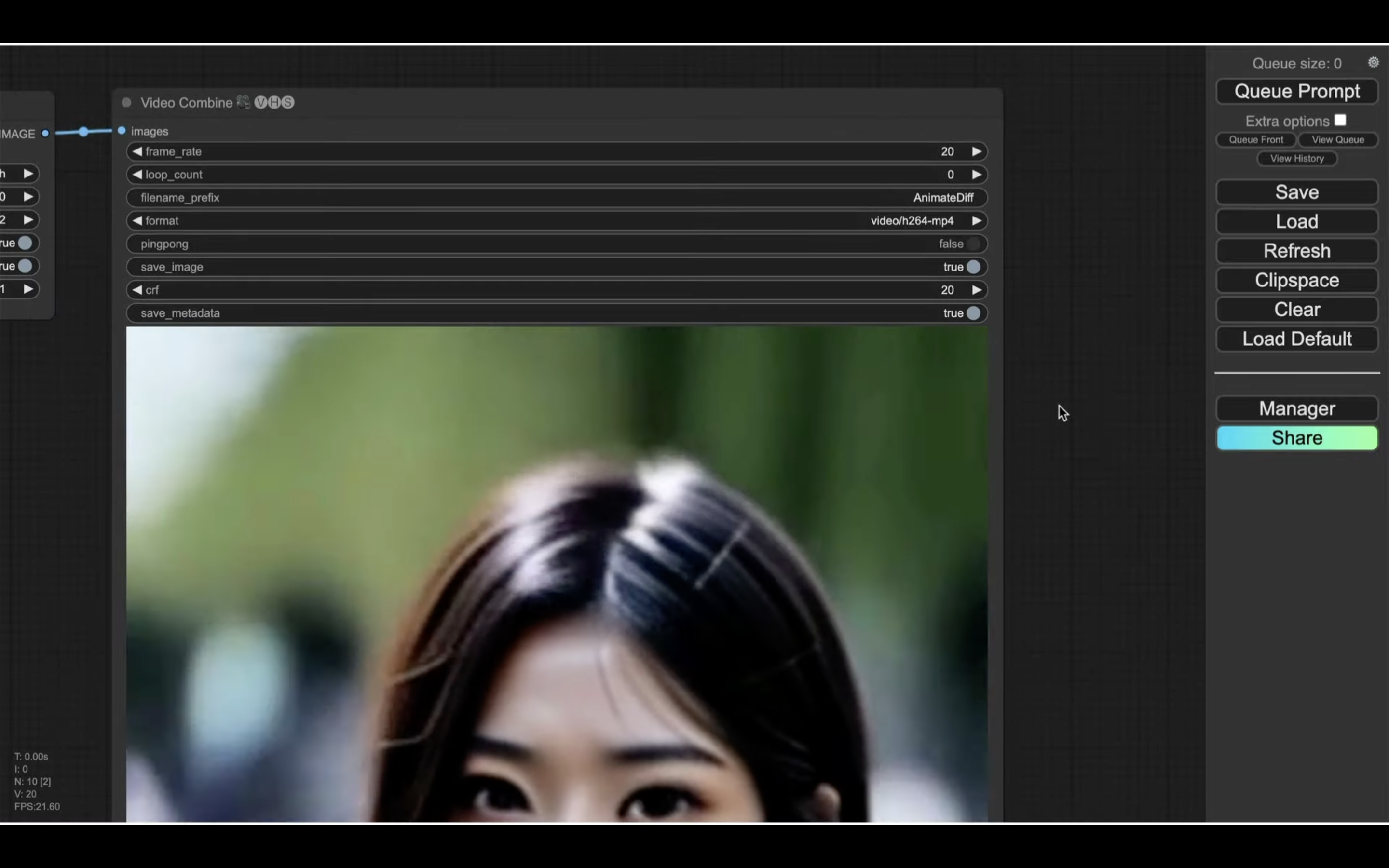

処理が完了したら、「Video Combine」というタイトルのブロックに生成された動画のプレビューが表示されます。

今回は、このような動画が生成されました。

動画全体が見れるようにズームアウトしておきます。

このようにStable Video Diffusionを利用すると、画像から動画を生成することができます。

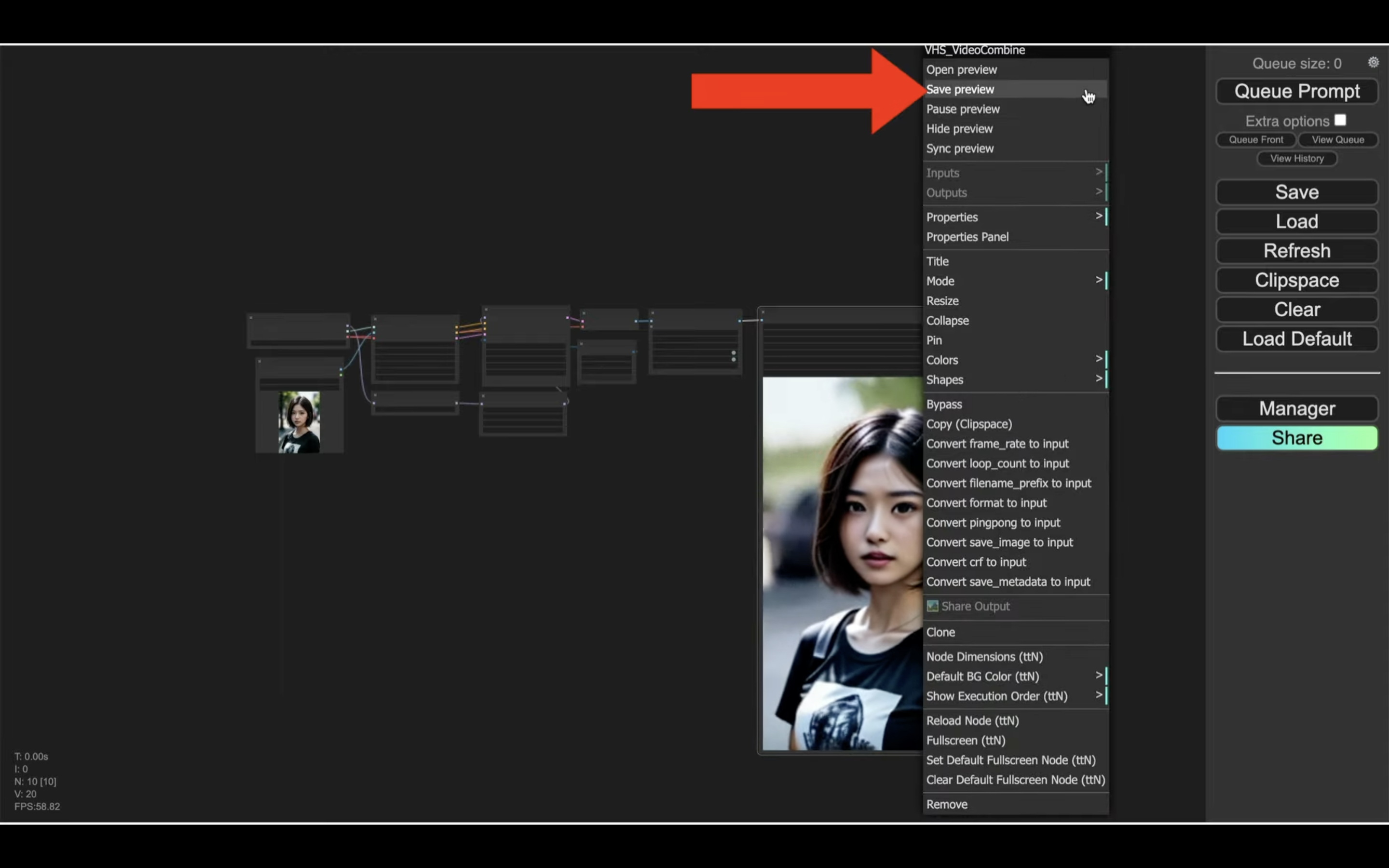

生成された動画をダウンロードするには、動画のプレビューが表示されている部分を右クリックします。

そして表示されたメニューの中から「Save preview」を選択します。

これで生成された動画をダウンロードすることができます。

是非お試しください。